Hoy, la plataforma Workers de Cloudflare es el lugar preferido de más de un millón de desarrolladores para crear complejas aplicaciones integrales que anteriormente no habrían sido posibles.

Por supuesto, Workers no empezó así. Surgió, en un día como hoy, como un anuncio con ocasión de una Semana aniversario. Ciertamente, puede que no tuviera tantas funciones como ahora, pero si tuviste la ocasión de probar Workers cuando lo lanzamos, habrás tenido la sensación de que era diferente y de que iba a cambiar las cosas. De repente, era posible pasar de no tener nada a tener una aplicación global y completamente escalable en cuestión de segundos, y no en horas, días, semanas o incluso meses. Era el inicio de un nuevo enfoque del desarrollo de aplicaciones.

Si has trasteado con la IA generativa en los últimos meses, es posible que hayas sentido lo mismo. Si preguntamos a amigos y colegas, quizás nuestra experiencia no haya sido idéntica, pero actualmente la sensación que prevalece en el sector es unánime: es diferente y va a cambiar las cosas.

Hoy nos complace hacer una serie de anuncios que creemos que tendrán un impacto similar al que tuvo Workers en el futuro de la informática. Sin más dilación, aquí tienes algunos de los más destacados:

- Workers AI (anteriormente conocido como Constellation), que se ejecuta en las GPU NVIDIA en la red global de Cloudflare, y lleva el modelo sin servidor a la IA. Paga solo por lo que uses, reduce tus gastos en infraestructura, y mucho más en tu aplicación.

- Vectorize, nuestra base de datos vectorial, que permite indexar y almacenar vectores de forma rápida, fácil y asequible, a fin de permitir casos de uso que requieren acceso no solo a modelos en ejecución, sino también a datos personalizados.

- AI Gateway, que proporciona las herramientas necesarias para el almacenamiento en caché, la limitación de velocidad y la observación de las implementaciones de IA, independientemente de dónde se ejecuten.

Pero eso no es todo.

Los grandes logros requieren el trabajo en equipo, y no queremos hacerlo solos. Como la mayoría de nuestras actividades, contamos con el apoyo de gigantes del sector. Estamos encantados de asociarnos con algunas de las organizaciones más importantes: NVIDIA, Microsoft, Hugging Face y Meta.

Nuestros anuncios de hoy solo marcan el principio del recorrido de Cloudflare en el ámbito de la IA, como Workers hizo hace seis años. Te animamos a que eches un vistazo a estos anuncios hoy mismo (no te decepcionarán). También hemos querido aprovechar para dar un paso atrás y ofrecerte una visión más amplia de la IA, y de cómo estos anuncios encajan en ella.

Inferencia: el futuro de las cargas de trabajo de IA

La IA consta de dos procesos principales: el entrenamiento y la inferencia.

El entrenamiento de un modelo de IA generativa es un proceso de larga duración (a veces meses) que consume muchos recursos informáticos y cuyo resultado es un modelo. Por lo tanto, las cargas de trabajo de entrenamiento son más adecuadas para ejecutarse en las ubicaciones tradicionales de nube centralizada. Teniendo en cuenta los recientes desafíos relacionados con la obtención de un acceso de larga duración a las GPU, y la consiguiente adopción por parte de las empresas de la multinube, hemos hablado acerca de cómo R2 puede proporcionar un servicio esencial que elimina las tarifas de salida de manera que se pueda acceder a los datos de entrenamiento desde cualquier nube informática. Pero hoy no estamos aquí para hablar de eso.

Si bien el entrenamiento requiere muchos recursos al principio, la tarea informática relacionada con la IA más omnipresente es la inferencia. Si últimamente has hecho alguna pregunta, generado una imagen o traducido algún texto en ChatGPT, has realizado una tarea de inferencia. Puesto que la inferencia es necesaria en cada invocación (no solo una vez), es de esperar que la inferencia será la carga de trabajo dominante relacionada con la IA.

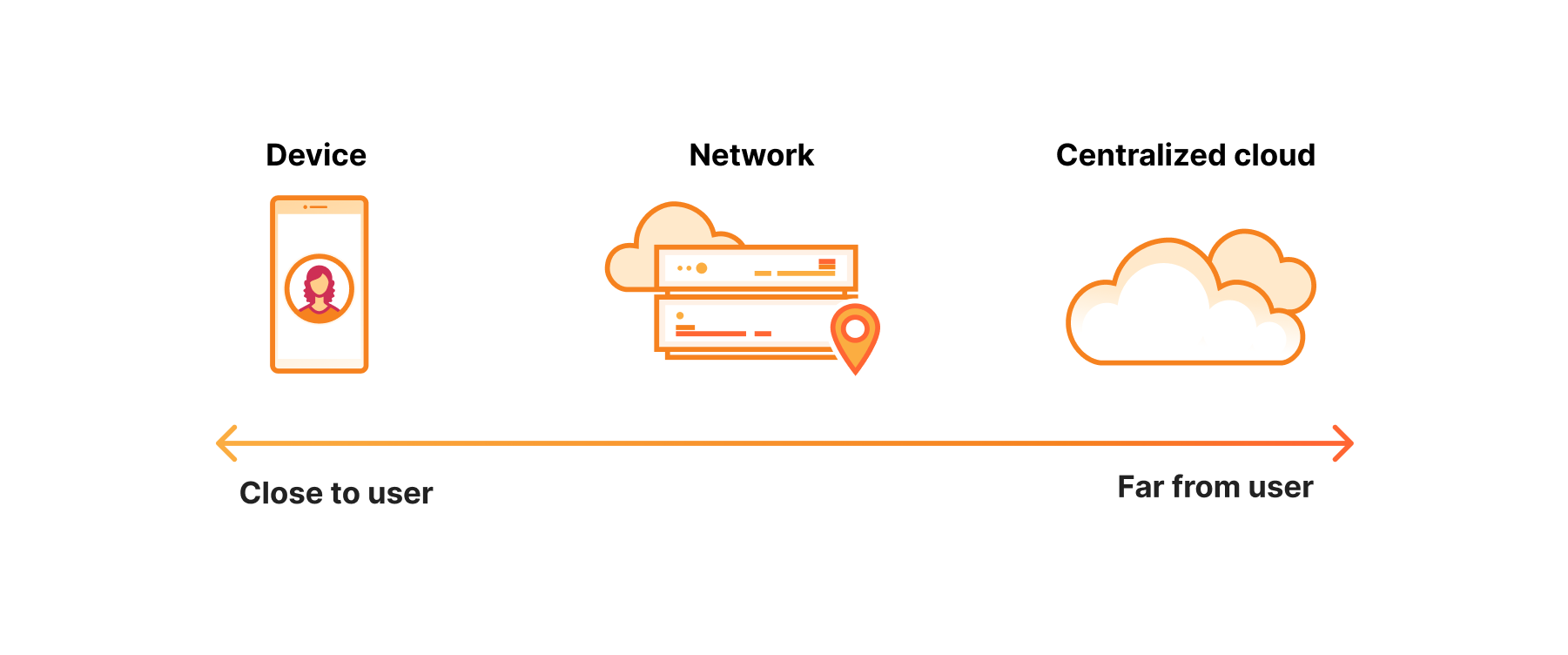

Si el entrenamiento es más adecuado para una nube centralizada, ¿cuál es la mejor ubicación para la inferencia?

La red, "justo lo que hace falta" para la inferencia

La característica principal de la inferencia es que suele haber un usuario a la espera en el otro extremo. Es decir, es una tarea donde la latencia es importante.

Podríamos pensar que la mejor ubicación para una tarea de este tipo sería el dispositivo. En algunos casos, esto podría ser así, pero surgen algunos problemas. Para empezar, el hardware de los dispositivos no tiene tanta potencia. La duración de la batería.

Por otro lado, dispones de los servicios de la nube centralizada. A diferencia de los dispositivos, lo que no falta en el hardware que se ejecuta en las ubicaciones de la nube centralizada es potencia. El problema, por supuesto, es que está a cientos de milisegundos del usuario. A veces incluso en otro país, por lo que presenta sus propios desafíos.

En resumen, los dispositivos no tienen la potencia suficiente y la nube centralizada está demasiado lejos. Esto hace que la red sea la piedra angular de la inferencia. No está demasiado lejos y tiene la potencia informática suficiente, es decir, justo lo que necesitas.

La primera nube de inferencia, que se ejecuta en Region: planeta Tierra

Una lección que hemos aprendido de la creación de nuestra plataforma para desarrolladores es que la ejecución de aplicaciones a escala de red no solo ayuda a optimizar el rendimiento y la escala (aunque obviamente esto es una ventaja considerable). También, y aún más importante, crea el nivel adecuado de abstracción para que los desarrolladores puedan avanzar rápidamente.

Workers AI para la inferencia sin servidor

Con el anuncio de Workers AI, llevamos la primera nube GPU realmente sin servidor a su socio ideal, Región: planeta Tierra. Sin conocimientos de aprendizaje automático ni búsquedas de GPU. Simplemente elige uno de nuestros modelos y listo.

Hemos reflexionado mucho acerca del diseño de Workers AI para lograr que la experiencia de implementación de un modelo sea lo más fácil posible.

Si implementas modelos en 2023, es muy probable que uno de ellos sea un LLM.

Vectorize para… ¡almacenar vectores!

Para crear un chatbot de extremo a extremo operado con IA, necesitas también poder presentar al usuario una interfaz de usuario, analizar la gran cantidad de información que deseas transmitirle (por ejemplo, tu catálogo de productos), utilizar el modelo para convertir esta información en datos integrados, y almacenarlos en algún lugar. Hasta ahora, ofrecíamos los productos que necesitabas para las dos primeras tareas. Sin embargo, la última (almacenar los datos integrados) requiere una solución específica: una base de datos vectorial.

Al igual que cuando anunciamos Workers poco después anunciamos Workers KV (poco puedes hacer con la informática sin acceso a los datos). Lo mismo sucede con la IA. Para crear casos de uso significativos de la IA, debes proporcionar a la IA acceso a los datos. Aquí es donde entra en juego una base de datos vectorial, y la razón por la que hoy nos complace anunciar Vectorize, nuestra base de datos vectorial.Vectorize para… ¡almacenar vectores!

AI Gateway para el almacenamiento en caché, la limitación de velocidad y la visibilidad de tus implementaciones de IA

En Cloudflare, cuando nos proponemos mejorar algo, el primer paso es siempre evaluarlo. Si no puedes evaluarlo, ¿cómo puedes mejorarlo? Cuando nuestros clientes nos comentaron sus dificultades para controlar los costes de la implementación de la IA, consideramos cómo enfocar la cuestión: primero evaluar los costes, luego optimizarlos.

AI Gateway te ayuda con ambos objetivos

Las prestaciones de observación en tiempo real permiten la gestión proactiva, lo que facilita la supervisión, la depuración y el ajuste de tus implementaciones de IA. Su uso es esencial para el almacenamiento en caché, la limitación de velocidad y la supervisión de las implementaciones de IA a fin de optimizar el rendimiento y una gestión eficaz de los costes. El almacenamiento en caché de las respuestas de IA utilizadas con frecuencia reduce la latencia y mejora la fiabilidad del sistema, al mismo tiempo que la limitación de velocidad garantiza una asignación eficaz de los recursos, lo que mitiga las dificultades relacionadas con el aumento descontrolado de los costes de la IA.

Colaboración con Meta para incorporar Llama 2 en nuestra red global

Hasta hace muy poco, la única posibilidad de acceder a un LLM era mediante llamadas a modelos propietarios. El entrenamiento de los LLM supone una inversión importante, tanto en tiempo como en recursos informáticos y financieros, lo que no está al alcance de la mayoría de los desarrolladores. El lanzamiento por parte de Meta de Llama 2, un LLM de código abierto, ha supuesto un gran cambio, ya que permite a los desarrolladores ejecutar e implementar sus propios LLM. Con la excepción, por supuesto, de un pequeño detalle: para ello aún necesitas acceso a una GPU.

Con la integración de Llama 2 en nuestro catálogo de Workers AI, esperamos proporcionar a todos los desarrolladores acceso a un LLM, sin necesidad de configuración.

Por supuesto, un modelo en ejecución no es más que uno de los elementos de una aplicación de IA.

Los desarrolladores utilizan el entorno de ejecución de ONNX para pasar sin problemas de la nube al perímetro y al dispositivo

Si bien el perímetro puede ser la ubicación óptima para resolver muchos de estos problemas, esperamos que la implementación de las aplicaciones se seguirá realizando en una gran variedad de ubicaciones en el dispositivo, el perímetro y la nube centralizada.

Por ejemplo, los coches autónomos. Cuando tomas decisiones donde cada milisegundo cuenta, debes tomar esas decisiones en el dispositivo. A la inversa, si deseas ejecutar versiones de los modelos que implican miles de millones de parámetros, la nube centralizada será más adecuada para tu carga de trabajo.

La cuestión que se plantea es: ¿cómo te mueves fácilmente entre estas ubicaciones?

Desde nuestra versión inicial de Constellation (ahora denominado Workers AI), una tecnología que nos parecía especialmente interesante era ONNX Runtime. ONNX Runtime crea un entorno estandarizado para la ejecución de modelos, lo que permite ejecutar distintos modelos en distintas ubicaciones.

Ya hemos hablado de que el perímetro es una ubicación ideal para la ejecución de la propia inferencia, pero también es fantástico como capa de enrutamiento a fin de guiar a las cargas de trabajo entre las tres ubicaciones sin problemas, en función del caso de uso y de lo que desees optimizar, ya sea la latencia, la precisión, el coste, el cumplimiento de normativas o la privacidad.

Nos asociamos con Hugging Face para poner modelos optimizamos al alcance de tu mano

Nada puede ayudar a los desarrolladores a avanzar más rápido que ir allí donde se encuentren, por lo que nos asociamos con Hugging Face para llevar la inferencia sin servidor a los modelos disponibles, allí donde los desarrolladores los exploran.

Nos asociamos con Databricks para crear modelos de IA

En colaboración con Databricks, llevamos la potencia de MLflow a los ingenieros y científicos de datos. MLflow es una plataforma de código abierto que permite gestionar de principio a fin el ciclo de vida del aprendizaje automático, y esta asociación facilitará a los usuarios la implementación y la gestión de modelos de aprendizaje automático a escala. Gracias a esta asociación, los desarrolladores que creen en Cloudflare Workers AI podrán utilizar los modelos compatibles con MLFlow para realizar fácilmente implementaciones en la red global de Cloudflare. Los desarrolladores pueden utilizar MLflow para agrupar, implantar, implementar y supervisar de forma eficaz un modelo directamente en la plataforma para desarrolladores sin servidor de Cloudflare.

La IA no quita el sueño a tu director de informática, tu director financiero o tu asesor general

La IA está evolucionando muy rápido, y es importante ofrecer a los desarrolladores las herramientas que necesitan para avanzar. Sin embargo, es difícil avanzar con rapidez cuando hay importantes cuestiones de las que preocuparse. ¿Y el cumplimiento de las normativas, los costes y la privacidad?

IA que cumple las normativas

Aunque la mayoría de nosotros preferiríamos no tener que pensar en ello, la residencia de datos y la IA están cada vez más reguladas por los gobiernos, que exigen que los datos se procesen a nivel local o que los datos de sus residentes se almacenen en el propio país, por lo que las empresas deben considerar también esa cuestión en el contexto de la ejecución de las cargas de trabajo de inferencia. En lo que respecta a la latencia, el perímetro de la red proporciona la capacidad de ir lo más lejos posible. En lo que se refiere al cumplimiento de las normativas, la eficacia de una red que abarca 300 ciudades, y una solución como Data Localization Suite, radica en que ofrece la granularidad necesaria para mantener las implementaciones de IA a nivel local.

IA a precio reducido

En nuestras conversaciones con muchos amigos y colegas que trastean con la IA parece haber una opinión generalizada: la IA es cara. Es fácil que se descontrolen los costes antes siquiera de haber llevado nada a producción o de haber sacado algún valor de ello. El objetivo de nuestra plataforma de IA es que los costes sean asequibles, pero posiblemente aún más importante, que solo pagues por lo que utilices. Tanto si utilizas Workers AI directamente o AI Gateway, queremos ofrecerte la visibilidad y las herramientas que necesitas para evitar que el gasto en IA se te dispare.

IA que respeta la privacidad

Si pones la IA en el centro de tus experiencias de usuario y de tus operaciones empresariales, debes confiar plenamente en que los datos que utiliza están en buenas manos. Como siempre hemos hecho en Cloudflare, nuestro enfoque prioriza la privacidad. Garantizamos a nuestros clientes que no utilizaremos los datos de nuestros clientes que pasan a través de Cloudflare para la inferencia a fin de entrenar modelos lingüísticos de gran tamaño.

No, realmente, esto es solo el principio

La IA está apenas empezando, ¡y nos espera una aventura increíble! Conforme seguimos descubriendo nuevas ventajas de esta tecnología, no podemos evitar el asombro y la admiración ante la infinidad de posibilidades que se abren ante nosotros. Ya se trate de revolucionar la sanidad o de transformar la forma de trabajar, la IA va a cambiar las reglas del juego de formas antes inimaginables. ¡Prepárate! Porque el futuro de la IA es más prometedor que nunca, y estamos impacientes por ver qué nos espera.

Este mensaje de resumen puede haber sido generado por IA, pero el sentimiento es auténtico: esto es solo el principio, y estamos impacientes por ver qué vas a crear.