Cloudflareは、2024年4月のDeveloper Weekで、Workers AIの一般提供を開始したことを発表しました。そしてこのたび、AI Gatewayも一般利用が可能になったことをお知らせします。2023年9月のBirthday Weekでベータ版を公開して以来、Cloudflareは5億件以上のリクエストをプロキシしています。現在、本番環境でご利用いただけるよう準備を整えています。

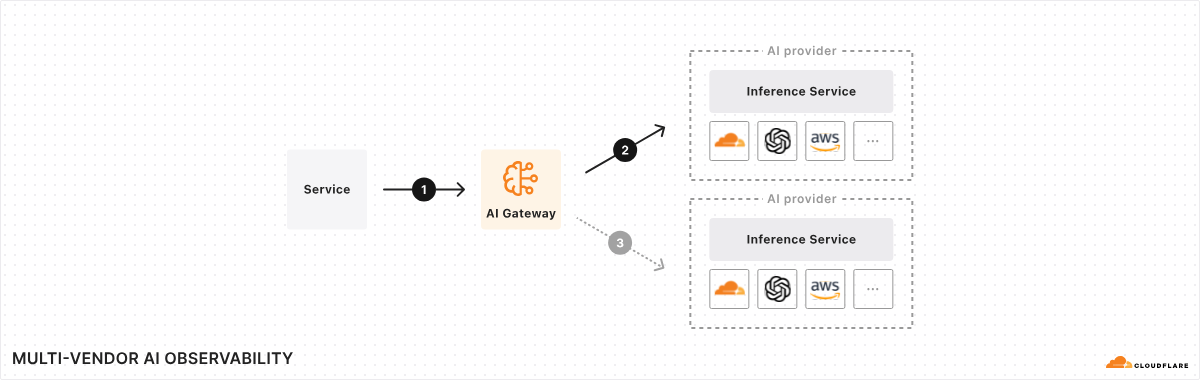

AI Gatewayは、生成AIワークロードの管理とスケーリングを行うための統合インターフェースを提供するAI運用プラットフォームです。その中核は、モデルがどこで実行されていても、サービスと推論プロバイダの間のプロキシとして機能する点にあります。ごくわずかなのコードで、パフォーマンス、セキュリティ、信頼性、可観測性に重点を置いた一連の強力な機能を利用できるようになります。AI運用のコントロールプレーンと考えるとよいでしょう。そしてこれはほんの始まりに過ぎません。近い将来、AI Gatewayにはたくさんの素晴らしい機能が搭載され、AIワークロードをさらに活用しようと考えるあらゆる組織にとって、最適なツールとなるはずです。

プロキシを追加する理由とCloudflareを使う理由

AI分野の進化は速く、毎日新たなモデル、プロバイダ、フレームワークが出現しているように思えます。この変化のスピードを考えると、特に複数のモデルやプロバイダを使用している場合、追跡は簡単ではありません。これは、AI Gatewayの公開の背後にある要因の一つです。Cloudflareは、たとえ翌日、翌々日にモデルやツールの変更があったとしても、すべてに対して一貫した唯一の制御プレーンを提供したいと考えています。

私たちは、AIアプリを構築している多くの開発者や組織と話をしましたが、一つだけはっきりしていることがあります。彼らはAI運用の可観測性、制御、ツールの向上を求めているのです。これは、モデル開発に注力するあまりにプラットフォーム機能がおろそかになるAIプロバイダの多くで欠けているものです。

AI GatewayにCloudflareを選ぶ理由については、そうですね、「しっくりくる」からです。Cloudflareは過去10年以上にわたり、最大規模のグローバルネットワークを運営し、世界中のお客様にパフォーマンス、信頼性、セキュリティを提供して、より良いインターネットの構築を支援してきました。Cloudflareは、世界中のWebサイトのほぼ20%でリバースプロキシとして使用されています。Cloudflareの専門性があれば、(AI GatewayにCloudflareを選ぶのは)ごく自然な成り行きのように感じられます。ユーザーは、一つのコントロールプレーンでコードをわずかに変更して、AIアプリの可観測性、信頼性、制御を実現し、構築の作業に戻ることができます。

ここでは、OpenAI JS SDKを使用したわずかなコード変更について紹介します。他のプロバイダ、SDK、言語については、Cloudflareのドキュメントを参照してください。

import OpenAI from 'openai';

const openai = new OpenAI({

apiKey: 'my api key', // defaults to process.env["OPENAI_API_KEY"]

baseURL: "https://gateway.ai.cloudflare.com/v1/{account_id}/{gateway_slug}/openai"

});現在の機能

ユーザーとの会話により、より高度な機能に移行する前に、基本的な機能に焦点を当てる必要があることが明らかになりました。現在、一般提供版で利用できる主な機能を以下に示します。今後もご期待ください。

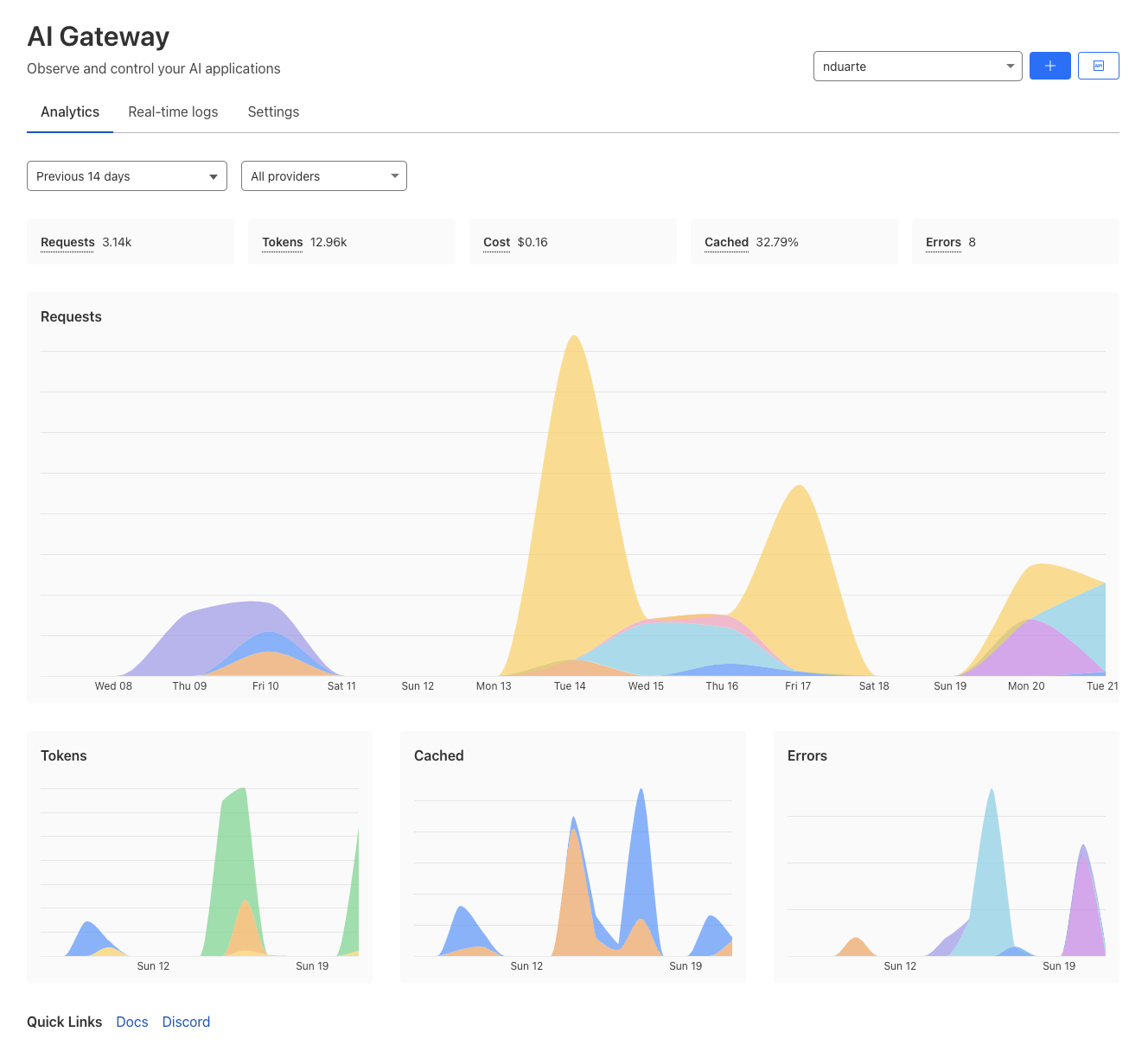

分析:複数のプロバイダからのメトリクスを集約。トラフィックパターンとリクエスト数、トークン、コストなどの使用状況を経時的に把握します。

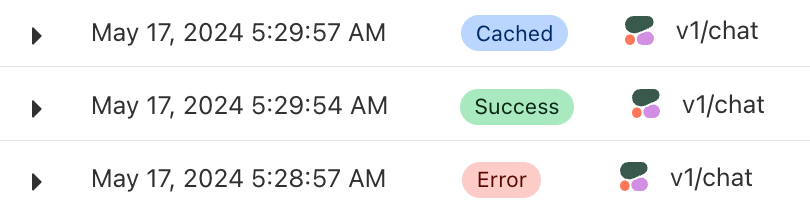

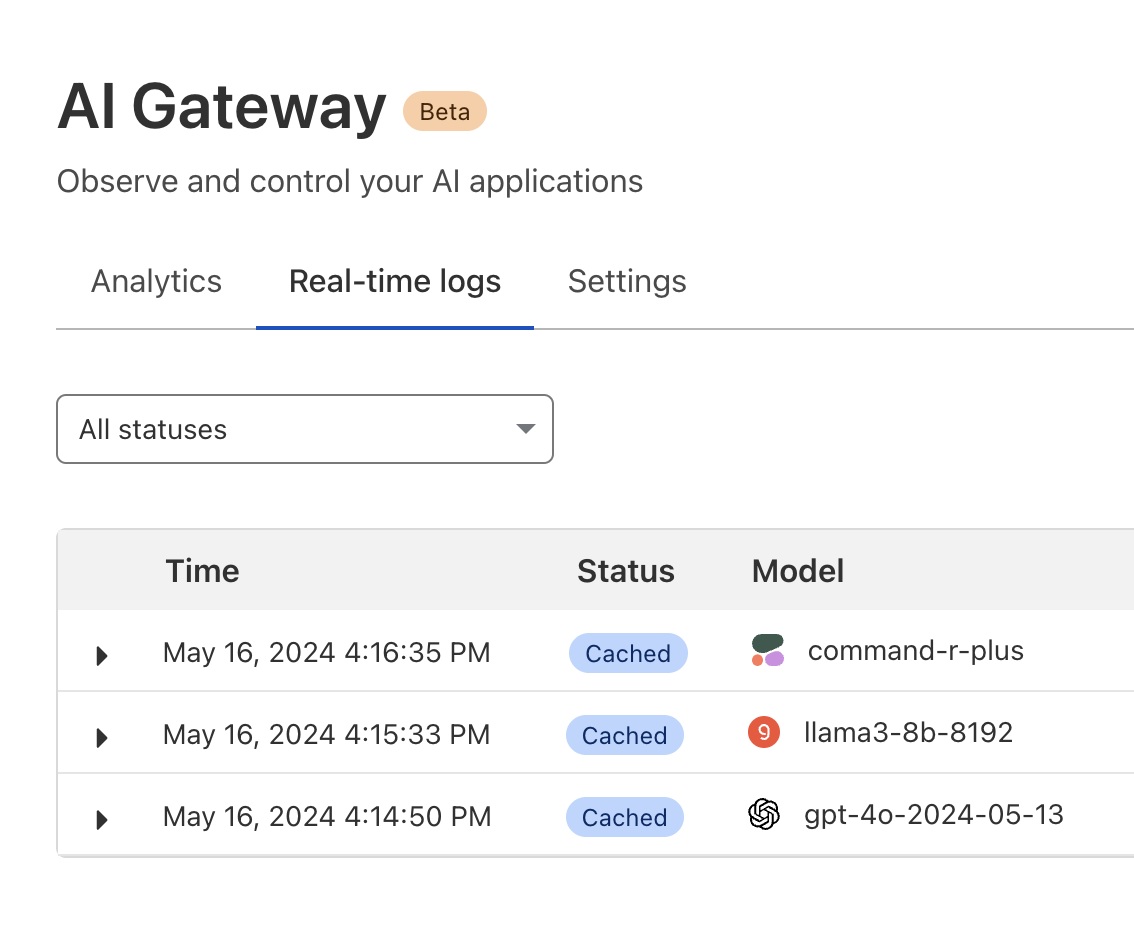

リアルタイムログ:ビルド時のリクエストやエラーに関する分析情報を提供します。

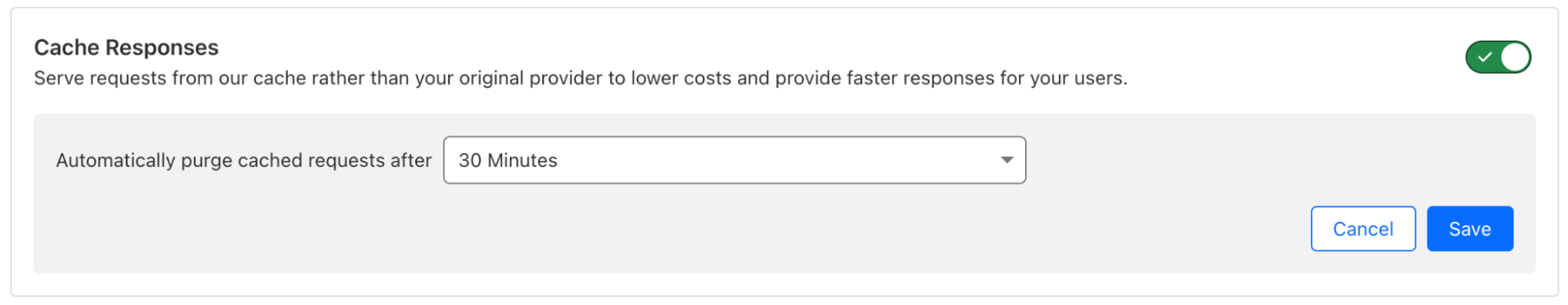

キャッシング:カスタムキャッシングルールを有効にして、元のモデルプロバイダAPIをヒットするのではなく、Cloudflareのキャッシュを繰り返しのリクエストに使用することで、コストの節減と遅延の抑制につなげることができます。

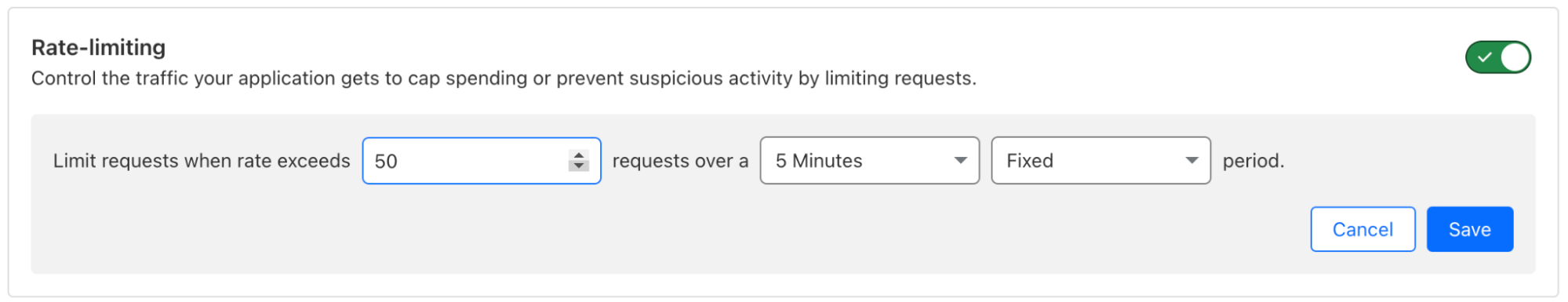

レート制限:アプリが受信するリクエスト数を制限して、アプリのスケーリングを制御し、コスト管理や不正使用防止を実現できます。

さまざまなプロバイダをサポート:AI Gatewayは、2024年5月中旬現在、Workers AIに加えてGroqやCohereなどの広く普及している10のプロバイダをネイティブサポートしています。

ユニバーサルエンドポイント:エラーが発生した場合、別のモデルや推論プロバイダへのリクエストフォールバックを定義することで、耐障害性が向上します。

curl https://gateway.ai.cloudflare.com/v1/{account_id}/{gateway_slug} -X POST \

--header 'Content-Type: application/json' \

--data '[

{

"provider": "workers-ai",

"endpoint": "@cf/meta/llama-2-7b-chat-int8",

"headers": {

"Authorization": "Bearer {cloudflare_token}",

"Content-Type": "application/json"

},

"query": {

"messages": [

{

"role": "system",

"content": "You are a friendly assistant"

},

{

"role": "user",

"content": "What is Cloudflare?"

}

]

}

},

{

"provider": "openai",

"endpoint": "chat/completions",

"headers": {

"Authorization": "Bearer {open_ai_token}",

"Content-Type": "application/json"

},

"query": {

"model": "gpt-3.5-turbo",

"stream": true,

"messages": [

{

"role": "user",

"content": "What is Cloudflare?"

}

]

}

}

]'今後の展開

開発者からは多くのフィードバックが寄せられていて、永続ログやカスタムメタデータはすでに予定されています。これらは魔法のサービスに必要な基礎的な機能です。

しかし、少し戻ってCloudflareのビジョンを説明しましょう。Cloudflareは、個々の部分の集合体よりも全体で統一されたプラットフォームの方が、はるかに強力であると考えています。この考え方をCloudflareのAI製品に適用した場合、使いやすく、組み合わせやすく、連携して実行できるものでなければならないのです。

次のステップを想像してみましょう。最初にWorkers AIにオンボードして、最新のオープンソースモデルで推論を実行します。次に、AI Gatewayを有効にして可視性と制御性を高め、永続ログの保存を開始します。その後、推論結果のチューニングを開始します。永続ログ、プロンプト管理ツール、組み込みの評価機能を活用することになります。ここで、推論結果を改善するために分析に基づく決定を行います。データが改善されるたびに、さらなる改善を求めることになるでしょう。そこで、入力/出力にアノテーションを付けるためのフィードバックAPIを実装し、構造化されたデータセットを構築します。この時点で、ワンクリックで微調整して、即座にCloudflareのグローバルネットワークにデプロイするまであと一歩です。ログとフィードバックを収集し続けることで、微調整アダプターの再構築を継続的に行い、エンドユーザーにベストな結果を提供することができます。

現時点ではあくまで理想的な話に過ぎませんが、私たちはこのようにAI GatewayとAIスイート全体の未来を想像しています。最も基本的なセットアップから始め、徐々に高度なワークフローへの進化をCloudflareのAIプラットフォームだけ完結できるはずです。上述の未来とは全く同じにはならないかもしれませんが、私たちは、最高のAI運用ツールを提供して、AIの最高の環境となれるよう、全力を尽くします。

開始方法

AI Gatewayは、現在すべてのプランでご利用いただけます。まだAI Gatewayを使用されていない方は、開発者向けドキュメントをご覧いただき、今すぐ使用を開始しましょう。現在利用可能なAI Gatewayのコア機能は無料提供されていて、Cloudflareアカウントとわずかなコードだけで開始できます。将来的には、永続ロギングやシークレット管理などのプレミアム機能も有料で利用できるようになります。ご質問は、CloudflareのDiscordチャンネルにお寄せください。