Wir freuen uns, Ihnen heute die Beta-Version von AI Gateway vorzustellen – dem Portal, das Ihre KI-Anwendungen besser beobachtbar, zuverlässiger und skalierbarer macht.

AI Gateway befindet sich zwischen Ihrer Anwendung und den KI-APIs, an die Ihre Anwendung Anfragen stellt (wie z. B. OpenAI). Dadurch können wir Antworten cachen, Anfragen begrenzen und wiederholen und Analytics bereitstellen, um Sie bei der Überwachung und dem Tracking der Nutzung zu unterstützen. AI Gateway kümmert sich um die Dinge, die fast alle KI-Anwendungen benötigen, und spart Ihnen Entwicklungszeit, damit Sie sich auf Ihre eigentliche Arbeit konzentrieren können.

Ihre App mit AI Gateway verbinden

Für den Einstieg in das AI Gateway von Cloudflare genügt eine einzige Codezeile. Sie müssen lediglich die URL in Ihren API-Aufrufen durch Ihren individuellen AI Gateway-Endpunkt ersetzen. Bei OpenAI definieren Sie beispielsweise Ihre baseURL als "https://gateway.ai.cloudflare.com/v1/ACCOUNT_TAG/GATEWAY/openai" anstelle von "https://api.openai.com/v1" – und das war’s. Sie können Ihre Token in Ihrer Code-Umgebung aufbewahren, und wir protokollieren die Anfrage durch AI Gateway, bevor wir sie mit Ihrem Token an die endgültige API weiterleiten.

// configuring AI gateway with the dedicated OpenAI endpoint

const openai = new OpenAI({

apiKey: env.OPENAI_API_KEY,

baseURL: "https://gateway.ai.cloudflare.com/v1/ACCOUNT_TAG/GATEWAY/openai",

});

Wir unterstützen derzeit Provider wie OpenAI, Hugging Face und Replicate und werden in Zukunft weitere hinzufügen. Wir unterstützen alle verschiedenen Endpunkte innerhalb der Provider und auch Response Streaming, sodass alles direkt ab der Konfiguration von Gateway funktionieren sollte. Der spezielle Endpunkt für diese Provider ermöglicht Ihnen, Ihre Apps mit AI Gateway zu verbinden, indem Sie eine einzige Codezeile ändern, ohne Ihre ursprüngliche Nutzlaststruktur zu verändern.

Wir haben auch einen universellen Endpunkt, den Sie verwenden können, wenn Sie sich mehr Flexibilität bei Ihren Anfragen wünschen. Mit dem universellen Endpunkt haben Sie die Möglichkeit, Fallback-Modelle zu definieren und Wiederholungsanfragen zu verarbeiten. Nehmen wir beispielsweise an, es wurde eine Anfrage an OpenAI GPT-3 gestellt, aber die API war offline. Mit dem universellen Endpunkt können Sie Hugging Face GPT-2 als Fallback-Modell definieren und das Gateway kann diese Anfrage dann automatisch an Hugging Face senden. Dieses Feature hilft, die Ausfallsicherheit Ihrer App zu verbessern, wenn Sie ungewöhnliche Fehler feststellen, Durchsatzbegrenzungen erhalten oder wenn eine Rechnung zu teuer wird und Sie auf andere Modelle ausweichen möchten. Mit dem universellen Endpunkt müssen Sie lediglich Ihre Nutzlast anpassen, um den Provider und den Endpunkt anzugeben, damit wir die Anfragen für Sie richtig routen können. Weitere Einzelheiten zum Schema des universellen Endpunkts finden Sie in der Beispielanfrage unten und in der Dokumentation.

# Using the Universal Endpoint to first try OpenAI, then Hugging Face

curl https://gateway.ai.cloudflare.com/v1/ACCOUNT_TAG/GATEWAY -X POST \

--header 'Content-Type: application/json' \

--data '[

{

"provider": "openai",

"endpoint": "chat/completions",

"headers": {

"Authorization": "Bearer $OPENAI_TOKEN",

"Content-Type": "application/json"

},

"query": {

"model": "gpt-3.5-turbo",

"stream": true,

"messages": [

{

"role": "user",

"content": "What is Cloudflare?"

}

]

}

},

{

"provider": "huggingface",

"endpoint": "gpt2",

"headers": {

"Authorization": "Bearer $HF_TOKEN",

"Content-Type": "application/json"

},

"query": {

"inputs": "What is Cloudflare?"

}

},

]'

Gewinnen Sie Einblick in die Nutzung Ihrer Apps

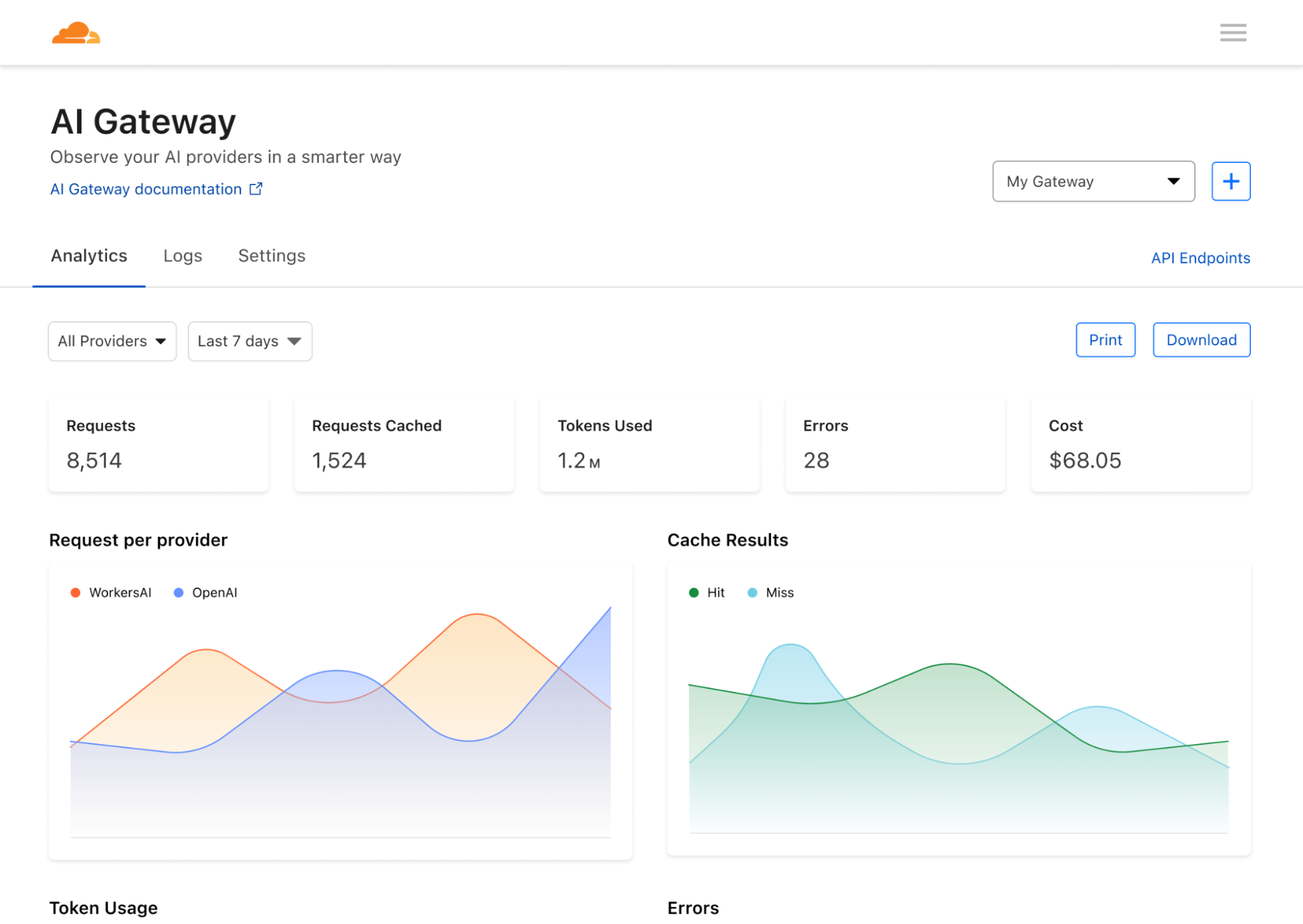

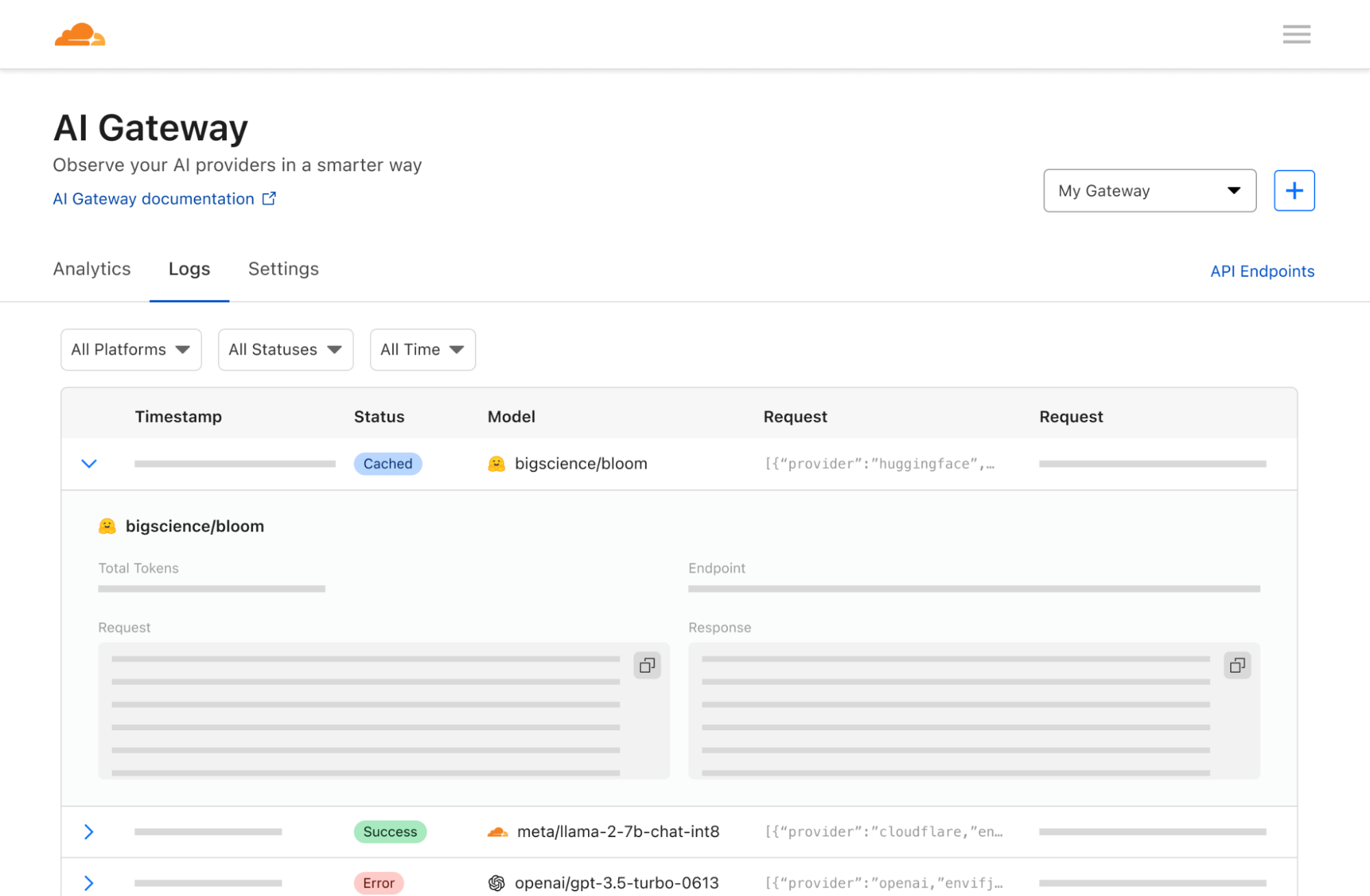

Jetzt, da Ihre App mit Cloudflare verbunden ist, können wir Ihnen helfen, Analytics-Daten zu sammeln und Einblicke und Kontrolle über den Traffic in Ihren Apps zu erhalten. Unabhängig davon, welches Modell oder welche Infrastruktur Sie im Backend verwenden, können wir Ihnen helfen, Anfragen zu protokollieren und Daten zu analysieren, darunter auch die Anzahl der Anfragen, die Anzahl der Nutzenden, die Kosten für den Betrieb der App und die Dauer der Anfragen. Obwohl dies grundlegende Analytics sind, die Modell-Provider eigentlich offenlegen sollten, ist es überraschend schwierig, mit den herkömmlichen Modell-Providern Einblick in diese Metriken zu erhalten. AI Gateway geht noch einen Schritt weiter und ermöglicht die Aggregation von Analytics über mehrere Provider hinweg.

Kontrolle über die Skalierung Ihrer Apps

Einer der häufigsten Kritikpunkte ist der hohe Preis für die Entwicklung und den Betrieb von KI-Apps. Jeder API-Aufruf kann unvorhersehbar teuer werden und die Kosten können schnell in die Höhe schießen. Das hält Entwicklungsteams davon ab, ihre Apps auf das volle Potenzial zu skalieren. Bei der rasanten Entwicklung der Branche wollen Sie nicht durch Ihre Skalierung ausgebremst werden und auf der Strecke bleiben – und genau hier helfen Caching und Durchsatzbegrenzung. Wir ermöglichen es Entwicklern und Entwicklerinnen, ihre API-Aufrufe zu cachen, sodass neue Anfragen aus unserem Cache und nicht aus der ursprünglichen API bedient werden können. Das macht sie günstiger und schneller. Die Durchsatzbegrenzung kann auch zur Kostenkontrolle beitragen, indem sie die Anzahl der Anfragen drosselt und übermäßige oder verdächtige Aktivitäten verhindert. Entwicklungsteams können flexibel Regeln für das Caching und die Durchsatzbegrenzung festlegen, sodass Apps in dem gewünschten, nachhaltigen Tempo skaliert werden können.

Die Workers AI-Plattform

AI Gateway lässt sich perfekt mit unseren neuen Produkten Workers AI und Vectorize kombinieren, sodass Sie Full-Stack-KI-Anwendungen innerhalb des Workers-Ökosystems erstellen können. Von der Bereitstellung von Anwendungen mit Workers, der Ausführung von Modellinferenz an der Edge mit Workers AI, der Speicherung von Vektoreinbettungen mit Vectorize bis hin zum Einblick in Ihre Anwendungen mit AI Gateway – die Workers-Plattform ist Ihre zentrale Anlaufstelle, um KI-Anwendungen zum Leben zu erwecken. Wie Sie AI Gateway mit Workers AI oder den verschiedenen Providern nutzen können, erfahren Sie in der Dokumentation.

Der nächste Schritt: der Anwendungsfall für Unternehmen

Wir stellen AI Gateway v1 mit einigen essenziellen Funktionen bereit, aber wir planen, das Produkt zu erweitern, um auch fortgeschrittenere Anwendungsfälle abzudecken: Nutzungswarnungen, Schutz vor Jailbreak, dynamisches Modellrouting mit A/B-Testing und erweiterte Cache Rules. Was uns jedoch wirklich begeistert, sind die weiteren Möglichkeiten, wie Sie AI Gateway einsetzen können...

In Zukunft wollen wir AI Gateway zu einem Produkt entwickeln, das Unternehmen dabei hilft, zu überwachen und zu beobachten, wie ihre Nutzenden oder Mitarbeitenden KI nutzen. So können Sie auf Knopfdruck alle Anfragen innerhalb Ihres Netzwerks an Provider (wie OpenAI) zuerst über Cloudflare laufen lassen. Dadurch können Sie die Anfragen der Nutzenden protokollieren, Zugriffsrichtlinien anwenden sowie Durchsatzbegrenzungen und Strategien zum Schutz vor Datenverlust (Data Loss Prevention; DLP) aktivieren. Hier ein eindrucksvolles Beispiel: Wenn jemand aus Ihrem Team versehentlich einen API-Schlüssel in ChatGPT einfügt, kann AI Gateway so konfiguriert werden, dass es die ausgehende Anfrage sieht und den API-Schlüssel unkenntlich macht oder die Anfrage ganz blockiert, sodass sie OpenAI oder andere Endanbieter gar nicht erst erreichen kann. Wir können auch verdächtige Anfragen protokollieren und Alarm schlagen, damit Firmen proaktiv bestimmte Arten von Aktivitäten untersuchen und kontrollieren können. AI Gateway wird so zu einem wirklich leistungsstarken Werkzeug für Unternehmen, die zwar von dem Effizienzpotenzial der KI begeistert sind, aber zögern, der KI zu vertrauen, wenn Datenschutz und Nutzungsfehler wirklich kritische Bedrohungen darstellen. Wir hoffen, dass AI Gateway diese Bedenken zerstreuen kann und die Einführung von KI-Tools für Unternehmen viel einfacher macht.

Ganz gleich, ob Sie selbst Anwendungen entwickeln oder ein Unternehmen sind, das wissen will, wie die Beschäftigten KI nutzen – wir hoffen, dass AI Gateway Ihnen dabei helfen kann, die Vorgänge in Ihren Apps zu entmystifizieren. Denn wenn Sie erst einmal verstehen, wie Ihre Nutzenden KI verwenden, können Sie entscheiden, wie sie die Technologie tatsächlich einsetzen wollen. Einige dieser Features befinden sich noch in der Entwicklung, aber wir hoffen, dass dies die Leistungsfähigkeit von AI Gateway und unsere Vision für die Zukunft verdeutlicht.

Wir bei Cloudflare leben und atmen Innovation (wie Sie an unseren Ankündigungen zur Birthday Week unschwer erkennen können!) und das Innovationstempo in Sachen KI ist unglaublich. Wir sind begeistert, dass wir Menschen nicht nur helfen können, Apps zu entwickeln und zu nutzen, sondern auch die Einführung und Entwicklung von KI mit mehr Kontrolle und Transparenz zu beschleunigen. Wir können es kaum erwarten von Ihren Projekten zu hören – gehen Sie zum Cloudflare Dashboard, testen Sie AI Gateway und erzählen Sie uns, was Sie davon halten!